Por José Pedro Aragón Hernández.

La Lengua de Señas Mexicana o LSM, es el medio de comunicación de las comunidades sordas en las regiones urbanas y rurales de México. Es el idioma más utilizado, de 87,000 a 100,000 señantes (TC Smith-Stark, 1986), por lo que es más grande que muchas familias enteras de lenguas indígenas en el país. Es, según la Ley General para la Inclusión de las Personas con Discapacidad (Texto vigente publicado en el Diario Oficial de la Federación el 30 de mayo de 2011), “La lengua de una comunidad de sordos, que consiste en una serie de signos gestuales articulados con las manos y acompañados de expresiones faciales, mirada intencional y movimiento corporal, dotados de función lingüística, forma parte del patrimonio lingüístico de dicha comunidad y es tan rica y compleja en gramática y vocabulario como cualquier lengua oral”.

Esta brecha puede ser acortada mediante la detección de los gestos basándose en la Lengua de Señas Mexicana (LSM) convirtiendo las señas a cadenas de caracteres los cuales pueden ser representados como audio mediante APIS como Google Cloud Natural Language.

Para ello se plantea generar una simbiosis entre la detección de patrones en articulaciones usando la tecnología proporcionada por los dispositivos Kinect[1], originalmente usados para video juegos y la detección de patrones en articulaciones usando la tecnología para la detección de señas en las muñecas por medio de sensores electromagnéticos basándose en un producto de desarrollo llamado MyO[2].

La unión de los diversos elementos electromagnéticos que conforman el sistema nervioso en los brazos del ser humano generará el entorno de datos necesario para trabajar en la normalización y detección de datos, la cual puede ser aprovechada por las tecnologías de Google APIS para la interpretación en Lenguaje Natural, en nuestro caso español.

LSM puede ser separado en 2 áreas de trabajo:

- La primera área es la detección de los brazos, cuello, hombros, cadera, manos y codos, así como su posición relativa con respecto al cuerpo, para ello existen tecnologías actuales, comerciales y de bajo costo, entre ellas Microsoft Kinect la cual tiene la capacidad de detectar automáticamente los esqueletos. Cada esqueleto tiene 20 articulaciones:

Skeletal tracking significa seguimiento de esqueleto y se basa en un algoritmo que logra identificar partes del cuerpo de las personas que están en el campo de visión del sensor. Por medio de este algoritmo podemos obtener puntos que hacen referencia a las partes del cuerpo de una persona y hacer un seguimiento de éstos identificando gestos y/o posturas.

En este caso antes de iniciar la detección de los gestos, se debe trabajar en la visualización del esqueleto (Skeletal Tracking) para corroborar la detección en las posturas del cuerpo. En principio el trazo del esqueleto se realiza mediante vectores los cuales se recalculan en tiempo real, aunado a estos vectores, se realizó el remarcado de las articulaciones como puntos de referencia, cabe mencionar que en este trabajo sólo se considera la detección de los gestos que realizan los brazos con respecto a la cabeza y el dorso, ya que, para lenguaje sordo mudo, las piernas no tienen relevancia alguna.

- La segunda área de trabajo es quizás la más compleja ya que implica demasiadas variables; esta es la detección de las señas específicas de ambas manos en tiempo real usando los pulsos electromagnéticos generados por el sistema nervioso humano. Para ello se utiliza una tecnología de desarrollo llamada MyO.

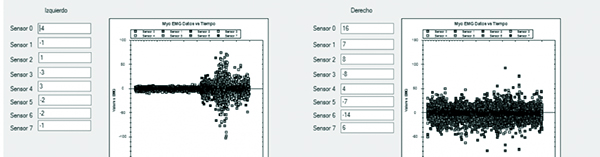

Con esta tecnología se pretende hacer uso de los 9 sensores EMG integrados, así como giroscopios para detectar los gestos efectuados en ambas manos de forma paralela para 10 señas como mínimo.

Los brazaletes Myo podrían ser utilizados para acercar más los mundos lingüísticos del lenguaje hablado y la lengua de señas utilizado por personas con capacidades diferentes, específicamente personas sordomudas mediante la conversión de la lengua de señas en cadenas de caracteres.

Al pensar en la integración de esta tecnología el problema se eleva exponencialmente, ya que se requiere la detección de los gestos de ambas manos. Lo cual incrementa de 10 a 20 sensores electromagnéticos que detectar simultáneamente.

Para realizar esta labor primero se debe generar un entorno de trabajo para monitorear el estado de cada uno de los dispositivos MyO, conocer los datos en tiempo real de cada sensor, y siguiendo el pensamiento de: “una imagen dice más que mil palabras”; los cientos de datos que genera por segundo nuestro sistema nervioso deben ser representados en graficas donde se compara valor sobre tiempo

¿Qué hacer con estos miles de datos?, ¿qué implementar para analizarlos?

La percepción normal dicta que miles de datos deben ser almacenados para su posterior análisis, la perspectiva moderna informática dicta usar paradigmas como NoSql, BigData, etcétera.

La percepción matemática dice que estos valores deben ser anotados en listas y analizar sus series, así como la función que realizan para comprender el resultado a alcanzar.

Conclusiones

Al momento de fusionar estas 2 áreas de trabajo en un producto para generar una caja negra que se unirá al arsenal de dispositivos trabajando en el internet de las cosas, será necesario eliminar todos los cálculos y presentación innecesarios para construir una plataforma más fluida y sólida, ya que aún falta la tercera área de trabajo, el habla natural en lenguaje español.

Las posibilidades aún son infinitas, y el trabajo que falta es igualmente infinito, mas no imposible.

El equipo de trabajo que desarrolla este proyecto está liderado por José Pedro Aragón Hernández, acompañado de José Luis Pérez Estudillo (Docente del Departamento de Sistemas y Computación), Francisco Javier Cartujano Escobar y Diana Karina Taboada Torres (ambos docentes del Departamento de Ciencias Económico Administrativas), todos ellos adscritos al Instituto Tecnológico de Zacatepec. ¶

(Publicado el 6 de febrero de 2018)

Fuentes de consulta

- Microsoft Authors in Kinect for Windows | Human Interface Guidelines v1.8, 2013 Ed. Microsoft Corporation; First Edition, 1-142.

- Abhijit Jana in Kinect for Windows SDK Programming Guide; 2012 Packt Publishing, first publishing, 19-355.

- Myo Gesture Control Armband | Wearable Technology by Thalmic Labs https://www.myo.com/

- MyoSharp, C# Wrapper for the Myo Armband https://github.com/tayfuzun/MyoSharp

[1] Kinect es un controlador de juego libre y entretenimiento creado por Alex Kipman, desarrollado por Microsoft para la videoconsola Xbox 360. Kinect permite a los usuarios controlar e interactuar con la consola sin necesidad de tener contacto físico con un controlador de videojuegos tradicional, mediante una interfaz natural de usuario que reconoce gestos, comandos de voz y objetos e imágenes.

[2] El brazalete Myo es un dispositivo de reconocimiento de gestos usado en el antebrazo y fabricado por Thalmic Labs. El Myo permite al usuario controlar la tecnología de forma inalámbrica utilizando varios movimientos de la mano. Utiliza un conjunto de sensores electromiográficos (EMG) que detectan la actividad eléctrica en los músculos del antebrazo, combinados con un giroscopio, un acelerómetro y un magnetómetro para reconocer los gestos.